Hoy te lo explica Álvaro Rondón experto SEO, así que comencemos y digamos que cada dominio o web tiene una autoridad que se mide por el pagerank, que varía por medio de la estrategia de enlaces o link building y la puede transmitir por medio de enlaces internos (hacia nuestra web) o externos (hacia otras web).

El motor de búsqueda de Google necesita dar una alta precisión en los resultados por eso desarrolla algoritmos, para ir perfilando y dando una mejor respuesta para cada búsqueda. El pagerank digamos que es un conjunto de algoritmos que puntúan una web o documento en base a diferentes cálculos, y lo puntúa de 0 a 10, antiguamente era público, y a pesar de lo que muchos dicen. SÍ, sigue vigente solo que no se actualiza de forma pública.

Pues hasta un punto cercano, aunque el punto de partida es bastante antiguo, digamos que tenemos la fórmula de la patente que se presentó el 9 de enero 1998, dirás Rondón, que me estás contando hace 20 años de esta patente, vale pero hemos ido investigando, patentes relacionadas y mejorando el conocimiento (posible), sobre como pondera estos algoritmos más o menos actualmente.

Aquí tienes la patente de page rank

Evidentemente han ido mejorando y ha recibido modificaciones pero podemos extraer muchísima información relevante. Sé que para muchos ver la patente y nada es lo mismo, no solo por que meten tecnicismos también por el idioma, así que la comentaré.

En un principio comenta la importancia de mejorar el sistema puesto que les costaba dar resultados segmentados por la calidad y que muchas urls podrían ser eliminadas en resultados de búsqueda cuando podrían ser incluso mejores que otros documentos o webs que estan en posicion top, además hablan de que en muchos casos, actualmente (ojo que habla sobre el año 2000), la manera de controlar los resultados era por varias técnicas y algoritmos que intentan presentar documentos más relevantes. Normalmente, los documentos se clasificaban según las variaciones de un modelo de espacio vectorial estándar.

Por cierto Gary illyes en 2017 dijo: ¿Sabes que después de 18 años seguimos usando PageRank (y cientos de otras señales) en la clasificación?

Entendiendo la fórmula de PageRank

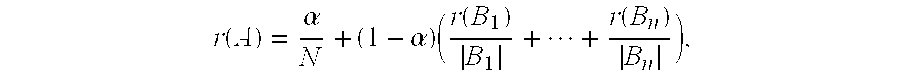

La fórmula de PageRank se ve así:

PR(A) = (1-d) + d * (PR(T1)/L(T1) + … + PR(Tn)/L(Tn))

Donde:

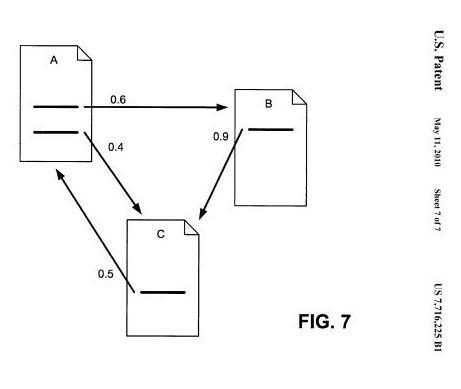

Supongamos que tenemos cuatro páginas web (A, B, C y D) que se enlazan entre sí de la siguiente manera:

Usando la fórmula de PageRank y un conjunto de iteraciones, calculamos el PageRank de cada página. En este ejemplo simplificado, obtenemos aproximadamente los siguientes valores de PageRank:

Estos valores indican la importancia relativa de cada página en función de sus enlaces entrantes.

Donde d es el factor de amortiguamiento que suele ser 0.85.

Para simplificar aún más el ejemplo, supongamos que todas las páginas comienzan con un PageRank inicial de 1.

PR(A) = (1 – 0.85) + 0.85 * (PR(C) / L(C)) PR(A) = 0.15 + 0.85 * (1 / 1) = 1

PR(B) = (1 – 0.85) + 0.85 * (PR(A) / L(A) + PR(D) / L(D)) PR(B) = 0.15 + 0.85 * (1 / 2 + 1 / 2) = 0.575

PR(C) = (1 – 0.85) + 0.85 * (PR(A) / L(A) + PR(B) / L(B) + PR(D) / L(D)) PR(C) = 0.15 + 0.85 * (1 / 2 + 1 / 1 + 1 / 2) = 1.075

PR(D) = (1 – 0.85) + 0.85 * 0 = 0.15

PR(A) = 0.15 + 0.85 * (PR(C) / L(C)) = 0.15 + 0.85 * (1.075 / 1) = 1.01375 PR(B) = 0.15 + 0.85 * (PR(A) / L(A) + PR(D) / L(D)) = 0.15 + 0.85 * (1 / 2 + 0.15 / 2) = 0.52625 PR(C) = 0.15 + 0.85 * (PR(A) / L(A) + PR(B) / L(B) + PR(D) / L(D)) = 0.15 + 0.85 * (1 / 2 + 0.575 / 1 + 0.15 / 2) = 0.98125 PR(D) = 0.15 + 0.85 * 0 = 0.15

Después de varias iteraciones, los valores de PageRank convergerían a un valor estable. En este ejemplo simplificado, el PageRank de cada página sería aproximadamente:

Dentro de las variaciones se presentaba, o bien la cercanía de los términos de búsqueda al comienzo del documento (variante b) (cosa que se sigue utilizando) o bien la variación A que es digamos la que están planteando, y viene a decir que esta estrategia proporciona resultados que son mejores que con el ranking en absoluto, pero que los resultados todavía tienen calidad relativamente baja.

Viene a decir que esta medida de relevancia es vulnerable a las técnicas de «spamming» que nosotros los seo más o menos conocemos como manipularla y que los resultados de búsqueda a menudo contienen documentos o webs que no corresponden a pesar de que los motores de búsqueda están diseñados para evitar tales manipulaciones, pues sigue sucediendo.

Entonces comentan que la solución podría ser la patentada, como un sistema de detección de menciones o lo que conocemos como backlinks, viene a decir que el sistema lo que hace es entender cómo unos documentos se relacionan con otros por medio de enlaces con textos anclas y que se asigna un rango al documento basado en el grado en que los términos de búsqueda coinciden con las descripciones de los anchor en otras webs.

Este sistema se basa en otra patente de IDD Information Services llamado Hyperlink Search Engine, y comentan que bueno es un modelo demasiado simple, y ya que la idea, bien conocida de contar que un documento tenga más valor simplemente porque recibe muchos enlaces, no es la solución total, pues la estaban mejorando con esta patente.

Vamos que ya tenían en cuenta que también podríamos manipular esto, ya que aunque es válido decir que un documento con más «citas» (enlaces) ellos suponen todo como si fuera por así decirlo humano, el ejemplo del famoso, si de una persona hablan 300 personas y de otra 50, una es mas famosa que otra, ahora transformarlo personas por enlaces.

Mencionan también que evidentemente el sistema es mejorable porque en el caso de nichos cuyo contenido es de calidad e importancia relativamente uniformes, es válido suponer que un documento altamente citado debe ser de mayor interés que un documento con sólo una o dos citas. Pero que otros nichos con variaciones muy grandes de calidad y cohabitan todo tipo de webs, si solo se basan en el numero de citas y no en la calidad también de las mismas, una web con contenido basura tendria la misma valoración que otra con un contenido top y que reciba menos números de menciones.

Digamos que presentan varios modelos de clasificación, uno proporciona una clasificación objetiva basada en la relación entre documentos. Otro aspecto de la patente está dirigido a una técnica para clasificar documentos dentro de una base de datos cuyo contenido tiene una gran variación en calidad e importancia. Otra parte es proporcionar un método de clasificación de documentos que sea escalable y pueda aplicarse a toda la world wide web, estas invenciones de pagerank se atribuyen en un principio a Sergey Brin, Scott Hassan, Rajeev Motwani, Alan Steremberg y Terry Winograd.

También se comenta por encima que asignan valores a cada enlace, que además intervienen otros algoritmos de clasificación, dependiendo de la profundidad de los enlazados y los que enlazan, y la posibilidad de que una persona aleatoria que realiza ciertas peticiones de información siga múltiples enlaces termine en la página relevante y no se quede e la página sin importancia. Este método de clasificación asigna puntuaciones más altas a webs importantes que no a las no relevantes.

Ellos presentan esta fórmula más compleja mejorando el sistema que ya se había presentado por IDD Information Services llamado Hyperlink Search Engine:

Donde B1 —-> Bn son las páginas de backlink de A

Donde r (B1) —> R (Bn) son sus rangos

Donde | B1 | —-> Bn | son su número de enlaces directos, y α es una constante en el intervalo [0,1], y N es el número total de páginas en la web.

Está claro que este método es más complejo que el presentado por IDD Information Services, con esta ecuación acaban más o menos resolviendo darle más valor a ciertos enlaces que otros aunque luego siguen mejorándolo hasta un punto muy complejo como está a día de hoy.

Si no te aclaras siempre puedes pedirme un presupuesto seo. Aquí tienes todos mis servicios de posicionamiento WEB:

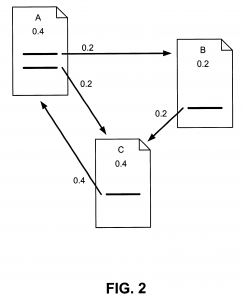

El rango de una página se puede interpretar como la probabilidad de que un usuario estará en la página después de seguir un gran número de enlaces directos. La constante α en la fórmula viene a presentar la probabilidad que existe en que un usuario salte de un enlace a otro de forma aleatoria sin seguir un enlace directo. A parte como menciono más abajo está muy relacionada con la patente de Reasonable surfer que tanto hemos escuchado estos últimos meses.

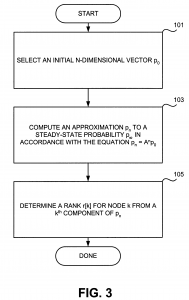

A partir de esta figura aparentemente simple desglosan una explicación que viene a resumir la complejidad de aplicarlo también de forma general al algoritmo. También se mencionan otras formas algorítmicas complejas, ya que comentan que también existen una gran mayoría de webs o urls sin enlaces que podrían ser de gran ayuda en muchos nichos, por eso presentan la figura 3.

Que establece una relación de un método implementado por ordenador para calcular un rango de importancia para N, nodos enlazados de una web enlazada, esto es bastante importante de aquí viene el porqué es tan importante el enlazado interno y la arquitectura de nuestra web.

También una parte muy importante de la patente es que esto modela el hecho de que los usuarios suelen saltar a un lugar diferente en la web después de seguir algunos enlaces. El valor de α es típicamente alrededor de 15%, es una amortiguación para que no exista una concentración artificial muy grande. Digamos que viene a comentar que no valoran igual los enlaces internos de una web que los externos, ya que el primero es más manipulable que el segundo, y que diferencian también la distancia entre los enlaces, que también tienen en cuenta que los enlaces de diferentes instituciones y autores en diversas ubicaciones geográficas o si los enlaces vienen de zonas como la home/root de un dominio que raramente sucede.

También comentan que un enlace cuanto más visible, y arriba podría valer también más, y subiría ese valor si el contenido se actualiza en el tiempo por no ser un contenido obsoleto. También se comenta aunque no tan determinante como en la patente reasonable surfer, el tema de la incitación al clic comentando que los enlaces reciben más fuerza si provocan que el enlace sea llamativo.

Cito textualmente: Elegimos nuestro nombre de sistema, Google, porque es una ortografía común de googol, o 10100 y encaja bien con nuestra meta de construir motores de búsqueda de gran escala.

Seguro que muchos no lo conocían.

Teniendo en cuenta que parte de la fórmula implica un valor que se saca de la posible interacción de un «surfista», pues hombre relacion tiene, cuando forma parte.

Partiendo de que la probabilidad de que la persona que navega visite una página al azar es su PageRank. Y, el factor de amortiguación es la probabilidad de que en cada página el «usuario aleatorio» se aburrirá y acabe solicitando otra página aleatoria, puede ser que el conjunto o dominio completo si pueda ser fácilmente manipulable, pero hacia una url precisa dentro de nuestra web sea muy complejo. Puesto que influye no solo donde, sino como, a qué distancia y desde que web se hace y hacía que web, la arquitectura de las mismas y el formato, ubicación y tambien que hace el usuario, ojo en el indice de google y no como muchos confunden en nuestra propia web.

No, depende de varios factores, principalmente va depender de si existe un atributo llamado REL que digamos detalla la relación que existe entre la url que enlaza y la que es enlazada.

Existen diferentes valores para este atributo:

Explica que la relación entre esa url y la nueva que enlaza es una alternativa, por ejemplo suele usarse @hreflang para explicar que existe una alternativa en otro idioma al actual o si usamos @media que explica la relación alterna por formato tipo audio, pdf, video o la típica versión para imprimir.

Código de ejemplo: <a rel=»alternate» hreflang=»en»> … </a>

Sinceramente está bastante bien explicado por google aquí como usar hreflang para urls de idioma y de región.

Digamos que este valor asocia el documento a un autor concreto.

Este valor muchos lo conocen porque hace unos años sobre 2013 aproximadamente se usaba para destacar al lado del articulo una foto del autor del mismo por medio de G+ (google plus) que aumentaba mucho el ctr porque destacaba bastante, duró poco tiempo y al final se ha dejado de usar para este fin. Os dejo una foto para los que no la pudisteis ver en su momento era esto:

Este valor implica que no traspase autoridad y que los bots no sigan el enlace. Es uno de los más conocidos pero peor usados, es más, muchos seos a pesar que digan que sabían perfectamente usarlo, no lo hacen, también por su evolución, en un principio se usaban para lo que es conocido por page rank sculpting, o en castellano manipular como fluye el link juice de forma interna y externa. Actualmente cualquier enlace nofollow siempre divide pero no transmite, así que como tal es una tontería usarlos para ESTA FUNCIÓN de forma interna, ya que estarás perdiendo de forma tonta parte del jugo.

Ejemplo de código:

<a href="alvarorondon.com/blog-seo/" rel="nofollow">Blog sobre seo</a>

Hubo un tiempo aunque Google dijera que no es así, que si que transmitía cierto juice, pero ahora si que Google no sigue estos enlaces, no transfiere PR (page rank) ni el anchor text (muchos se confunden porque lo ven herramientas como sistrix, ahrefs, majestic..etc..) por tanto no se incluye dentro del perfil de enlaces general de la web.

Pues bueno la verdad es que la cosa ya no es tan fácil como antes se pensaba, pero es cierto, que por medio de js (java script) que a pesar que lo puede renderizar e incluso rastrear si que no sabe interpretarlo o interactuar bien con el por tanto la web primero carga y luego se «escribe o pinta» ese enlace, o como hace Lino Uruñuela (es un must de blog seo español que hay que leer), que no solo usa estas técnicas sino que también codifica el enlace de forma que complica hasta un punto extremo que pueda, ya no solo interpretar sino ver ese enlace. Si quieres ver todo su articulo es este.

Hace unos días Luis, lo sé, le nombró en casi todos mis artículos, pero es que tenemos como simbiosis y cuando le pregunto por algo el tipo justo lo tiene preparado para sacar o viceversa. Bueno al caso que justo saca un video hablando de esto donde nombra también a Lino y todos los métodos.

Pensad en que el otro uso de nofollow es para mejorar el rastreo de nuestra web evitando que vaya hacia urls que no tenemos interés en que pierda presupuesto pero por el camino estamos perdiendo juice inevitablemente.

Con estos métodos no solo no perdemos juice sino que encima también podremos mejorar el crawl budget, aunque repito un punto de inflexión, sabiendo lo que hacemos porque puedes cargarte también el rastreo impidiendo que ciertas urls sean visibles ( si haces todos los menús con este método y no hay enlaces internos hacia esas urls).

Este valor sirve para relacionar de forma sugerente una url con otra donde estas especificando cual es la url preferida para mostrar el contenido a los usuarios.

Digamos que también es uno de los top conocidos y peor usados por muchos. Os aconsejo leeros estas dos entradas también de Google, aquí que explica cómo se usa rel canonical y aquí los 5 errores más comunes.

**Cuidado que si aplicas un canonical no apunte a una url que tenga una meta noindex

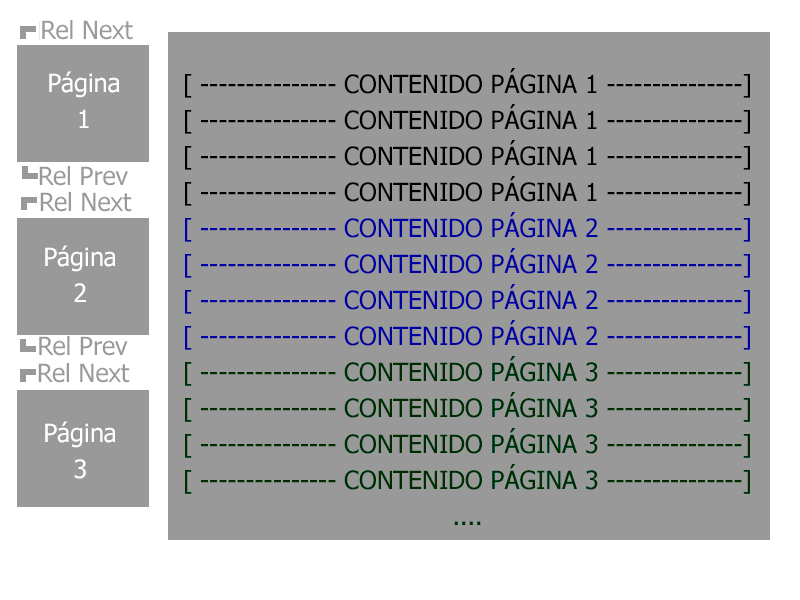

Sirve para indicar la relación de una url entre direcciones muy concretas para que las procese Google como una secuencia lógica.

Como matiz aclaro que google las trata como una sugerencia y no como una directiva otro ejemplo de esto son los canonicals (sugerencia) o 301 (directiva). También explicar que estos valores son ortogonales de canonical por tanto son compatibles entre ellos, es decir, puede existir un canonical y next y prev para indicar bien como tiene que entender esa arquitectura Google. Si quieres investigar más sobre esto aquí te explican muy bien como indicar el contenido paginado.

Una imagen vale más que mil palabras y esto es gracias a David Ayala que me avisó que no había puesto y encima el diseño lo hizo el jaja.

Hay otros valores que mencionar como help, bookmark, license, search, tag pero sinceramente o están obsoletas o no puedo decir que tengan relevancia entre su uso y el posicionamiento en buscadores como señal. De todas formas hay varias pruebas en camino aunque no puedo asegurar encontrar una correlación.

No, depende de si está contenido dentro del código principal o secundario, también cómo está metido, incluso el formato afecta, ya se ha comentado que existen patentes muy relacionadas con esto como es la patente Reasonable surfer que viene explicando que un enlace cuanto más incitación al clic tenga mejor valor recibe, desde la posición donde se encuentra hasta el formato que se diferencia por ejemplo por color, fuente, cursiva etc…para destacar del texto normal, también influye la relación que guarden como expliqué antes, y la cantidad de enlaces salientes de esa url.

Influyen otros factores más difíciles de manipular como:

Pero más o menos todo lo que quiere decir son probabilidades que puede existir sobre un enlace y las intentan llevar a números.

No, igual que no todos valen lo mismo, los internos o externos tampoco dividen el juice por igual, algunos como hemos explicado tienen más valor que otros, no va «consumir» el jugo de tu web igual un enlace interno desde un widget que en un contexto que encima incita al clic, está rodeado de texto, se encuentra en el main content, y demás.

Así que por poner un ejemplo claro:

Si tienes 4 enlaces internos desde una url hacia otras 4, algunos tendrán un 20% otros un 30 y así dependiendo de todo lo que hemos comentado y algunas cosas más complejas de explicar, antes se creía que repartían si fueran 4 enlaces pues un 25% cada uno. Google cada vez nos intenta poner más trabas para la comprensión de los algoritmos, incluso muchas veces explica lo que le interesa sin ser una verdad real como te he contado de la interpretación de javascript, lo rastrea, lo pinta pero no le hace ni caso a pesar que si es capaz de entender que ahí hay un enlace pero no lo interpreta como tal.